Zdroj: Dotekomanie.cz

4

Domů » Články » iOS »

Aktualizováno 4. 9.

Teprve minulý měsíc Apple představil novou technologii, s kterou chtěl odhalovat obsah spojený se sexuálním zneužíváním dětí v iCloud Fotkách. Dokonce jsme se dověděli, že tuto techniku používá již od roku 2019 ve služně iCloud Mail. Novinka měla být součástí nové verze iOS 15, ale veřejnost a i odborníci na soukromí se ozvali s výhradami a otázkami kolem bezpečnosti.

Objevily se i pochybnosti o samotném systému, kdy vlády, organizace a případně i jiné subjekty mohou manipulovat se zdrojovými daty s cílem odhalování identit některých osob nebo dohledávání jiných věcí. Jelikož Apple nemá přímo přístup k těmto datům a vše pracuje na systému NeuralHash, nemá možnost odhalit, pokud nějaká vládní organizace nezneužila systém.

Apple se rozhodl, že tento systém nezavede v iOS 15. Doslova uvádí, že si bere nějaký čas na dopracování a upravení celého systému. Odklad jako takový možná bude trvat několik měsíců, ale nebylo stanoveno ani přibližně datum, kdy dojde k zavedení.

Původní článek 6. 8.

Apple si velmi potrpí na soukromí uživatelů, což jde vidět snad v každé službě, aplikaci nebo systému, které vytváří. Například u iCloud umožňuje, aby uživatelé nechali šifrovat obsah, díky čemuž k němu nemá přístup ani Apple. To v podstatě vedlo k nemožnosti skenovat například fotografie. To se do jisté míry změní, zejména s ohledem na odhalování materiálu spojeného se sexuálním zneužíváním dětí.

NeuralHash

Apple pracoval na novém systému NeuralHash, který má za za cíl odhalit fotografie, které jsou spojeny se sexuálním zneužíváním dětí. V tomto případě ale nebude zasahovat do samotných šifrovaných dat v iCloud. Místo toho se rozhodl jít trochu jinou cestou. NeuralHash totiž bude pracovat na zařízení uživatele, nikoliv v cloudu, tedy v iCloud.

NeuralHach bude generovat specifický řetězec vytvořený z fotografie. Ten se následně porovná s databází známého obsahu právě kolem sexuálního zneužívání dětí. Tuto databázi poskytnou organizace zabývající se tímto problémem, například NCMEC (National Center for Missing & Exploited Children). Apple pracuje na vylepšené verzi, která bude moci odhalit i upravené fotografie, tedy oříznuté nebo zmenšené. Ke kontrole by mělo dojít těsně před tím, než se obsah dostane do iCloud.

Společnost dále uvádí, že jde zde několik vrstev ochran a filtrů, než se nějaký nález dostane k ruční kontrole. Novinka bude implementována do iOS 15 a macOS Monterey. Bude pracovat výhradně na zařízení uživatele. Dle dostupných informací bude fungovat zatím jen v USA, ale následně dojde k rozšíření do dalších zemí.

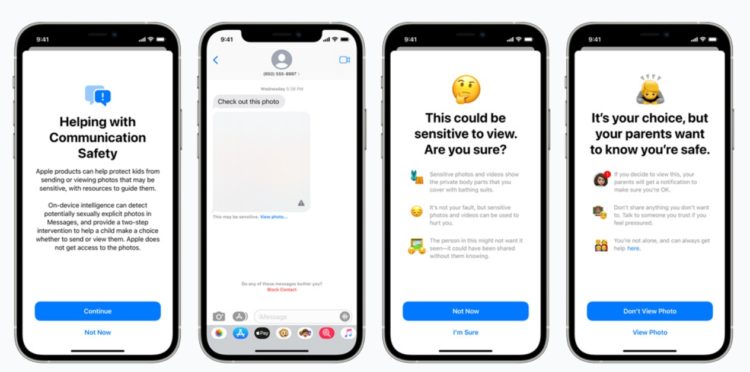

Dále dojde k nasazení podobného systému u iMessage u dětských účtů, přičemž zde bude aktivní kontrola, která upozorní uživatele. Kromě toho může také upozornit rodiče, že potomek odeslal nebo přijal obsah se sexuální tématikou. Také dojde k nasazení u Siri a Vyhledávání, kde po zadání dotazu s tématikou sexuálního zneužívání dětí dojde k upozornění na závadnost.

Apple dlouho odolával i tomuto skenování závadného obsahu, ale nakonec přichází s tímto řešením. Něco podobného řeší i další cloudové služby. Například Dropbox, Google a Microsoft něco podobného dělají již nyní.

Zdroje: techcrunch.com, techcrunch.com

Domů » Články » iOS »

Vivo zlevnilo všechny telefony. Nejnovější V21 5G je levnější o 2 tisíce [sponzorovaný článek]

Procesor Google Tensor zřejmě zamíří i do jiných zařízení

Stiknutím klávesy J se přesunete na starší článek, klávesa K vás přesune na novější.

💡 Získejte Dotekománie Premium a využijte web naplno.

![Apple odkládá skenování fotografií za účelem odhalování obsahu spojeného se zneužíváním dětí [aktualizováno]](https://dotekomanie.cz/wp-content/uploads/2020/11/iPhone_12_Max-5-5920x3323x.jpg)

Martin Jeřábek

Apple odkládá skenování fotografií za účelem odhalování obsahu spojeného se zneužíváním dětí.

Tomu určitě nevěříte že to bylo kvůli tomu 😂 Apple šmiráci jen rádi špehují a tak jak známé Emeriku tak ta se ráda skrývá za děti a svede to na zneužívání a přitom bude sledovat vše.. Ale proč ne tupé ovce to rádi přivítají.

Martin Jeřábek

Šmiráci opět v akci a ještě budou tvrdit že to dělají pro dobro lidí.

Eisy Thor

6. 8. 2021, 12:59Ten titulok, autor by ho mohol korigovat, lebo “s neužívaním detí“ vyznieva dost absurdne.

Jan Kasik

6. 8. 2021, 10:05A ovečky budou mít radost – vždyť Apple nešpehuje jako ten zlej Android/google on totiž jen skenuje a to samozřejmě jen pro dobrou věc :-)